[vc_row type=”in_container” full_screen_row_position=”middle” scene_position=”center” text_color=”dark” text_align=”left” overlay_strength=”0.3″ shape_divider_position=”bottom” bg_image_animation=”none”][vc_column column_padding=”no-extra-padding” column_padding_position=”all” background_color_opacity=”1″ background_hover_color_opacity=”1″ column_link_target=”_self” column_shadow=”none” column_border_radius=”none” width=”1/1″ tablet_width_inherit=”default” tablet_text_alignment=”default” phone_text_alignment=”default” column_border_width=”none” column_border_style=”solid” bg_image_animation=”none”][vc_column_text]

Niedawno świat obiegła wieść, że Samsung opracował technologię, która w oparciu o pojedyncze zdjęcie jest w stanie „ożywić” daną postać. Efekty mogą bawić. No bo przecież gadająca Mona Lisa czy Albert Einstein to niezła beka. Ale czy na pewno?

Znacie pojęcie „deepfake”? Poznajcie, bo gwarantujemy wam, że jeszcze nie raz o nim usłyszycie. Słowo to (będące zbitką wyrazową od angielskiego: deep learning – głębokie uczenie, oraz fake – fałszywy) jest używane do opisu techniki obróbki obrazu, polegającej na nałożeniu twarzy konkretnej osoby na dowolną postać i „ożywienie” jej przy użyciu sztucznej inteligencji.

Tak spreparowane nagranie może przedstawiać osoby mówiące rzeczy, których w życiu nie powiedziały, bądź wykonujące przed kamerami czynności, których nigdy w rzeczywistości nie robiły. Przykłady? Można mnożyć. Barack Obama ostrzegający przed konsekwencjami nieetycznego stosowania technologii cyfrowych (nagranie opublikowane w kwietniu 2018 r., były prezydent USA w rzeczywistości nigdy nie wypowiedział tych słów) czy Mark Zuckerberg, zwracający uwagę na zagrożenia, jakie niosą cyfrowe technologie (nagranie z czerwica 2019 r.)… A to tylko wierzchołek góry lodowej.

Samo zresztą pojęcie „deepfake”, które pojawiło się po raz pierwszy w debacie publicznej w końcu 2017 r., wzięło się od pseudonimu użytkownika, który opublikował kilka filmów porno zrealizowanych przy użyciu algorytmu uczenia maszynowego z wykorzystaniem wizerunków m.in. Gal Gadot, Maisie Williams i Taylor Swift.

Jedno zdjęcie wystarczy

Mówimy o tym wszystkim dlatego, że do tej pory stworzenie realistycznie wyglądającej animacji wymagało użycia wielu nagrań lub zdjęć. Nie wspominając już o sprzęcie, programach komputerowych i umiejętnościach.

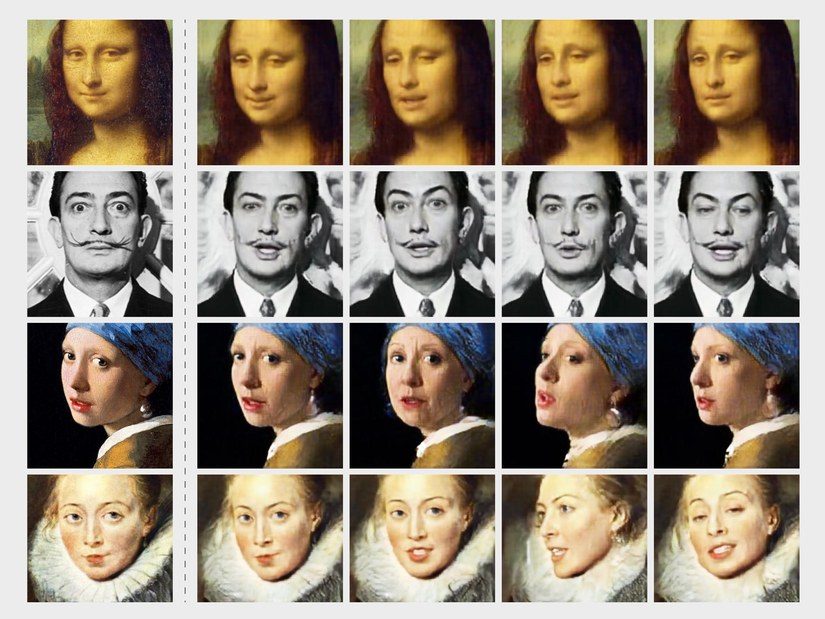

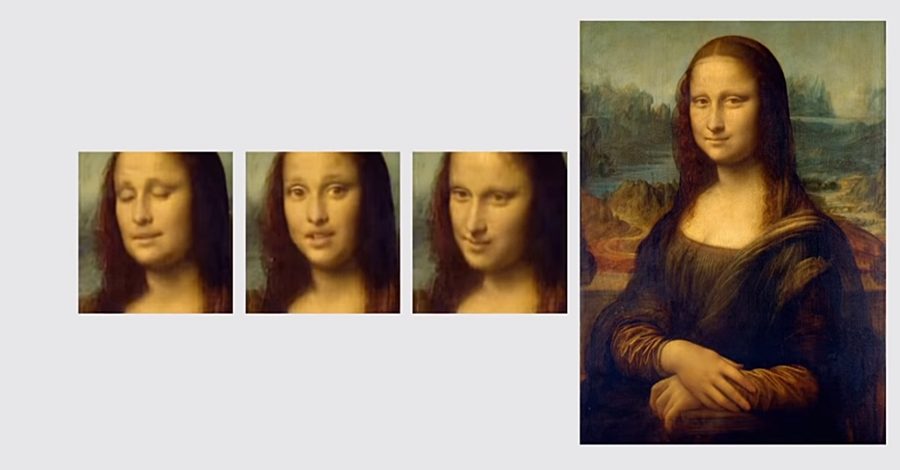

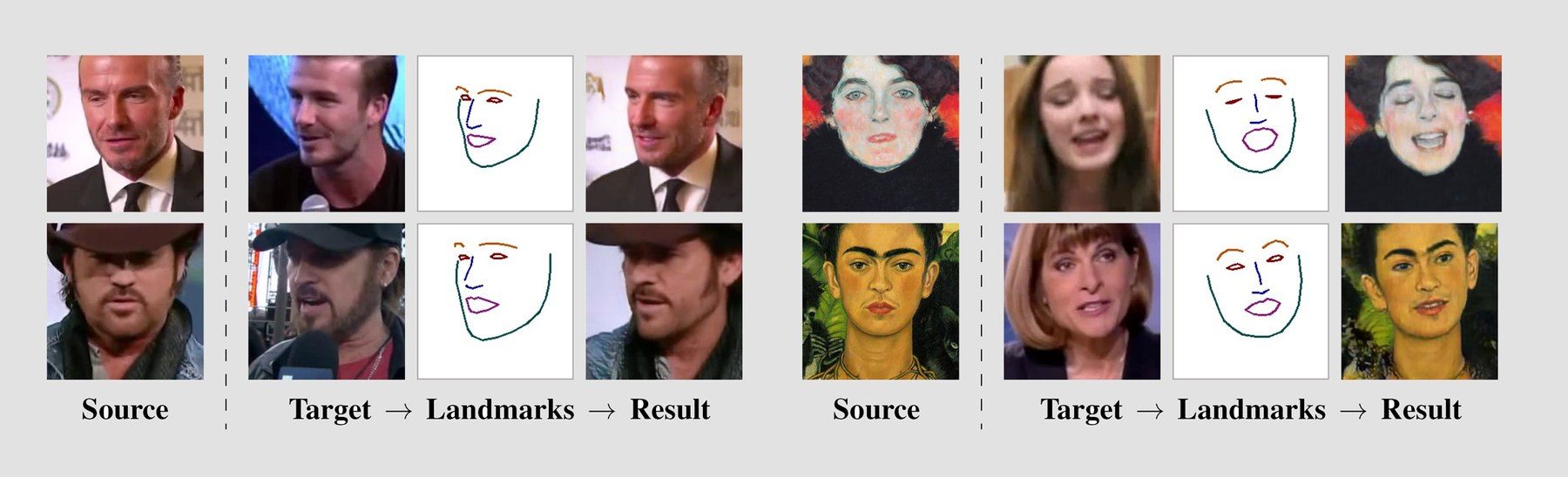

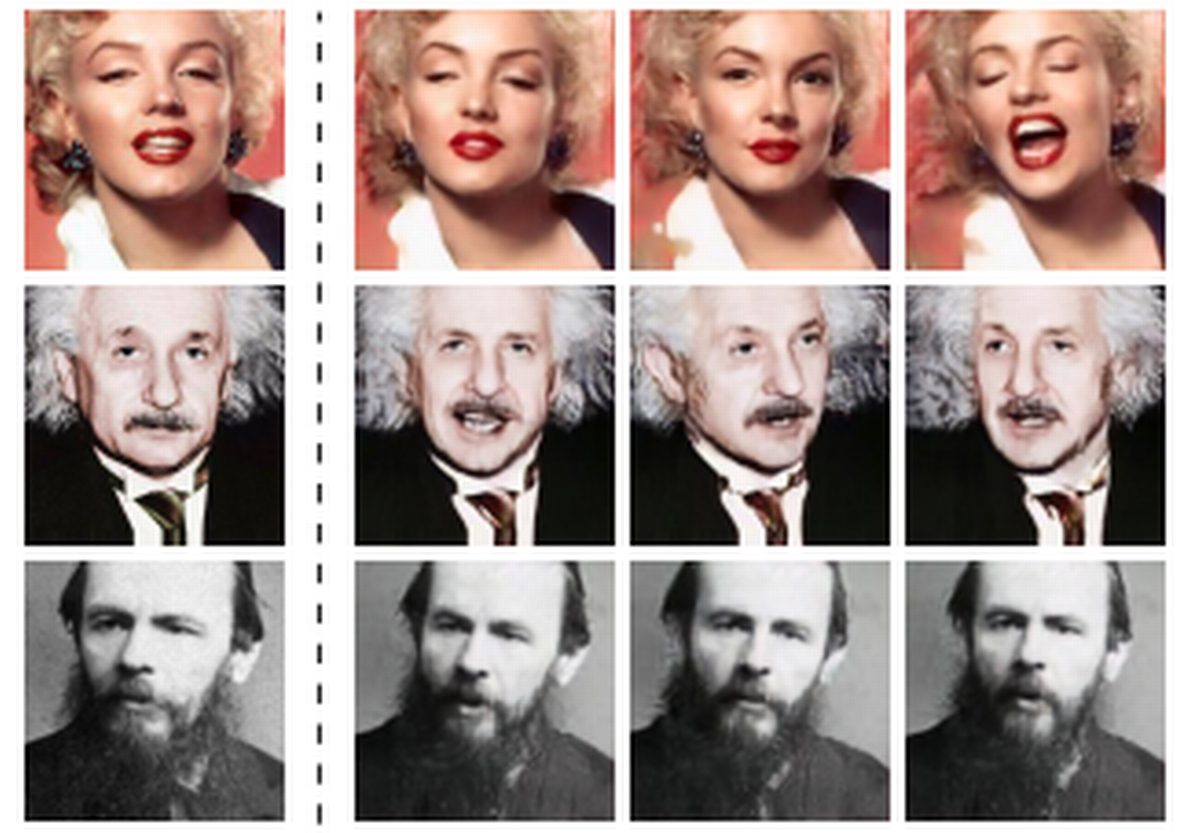

Sytuację diametralnie odmieniło dokonanie specjalistów z Samsung Research Artificial Intelligence Center (SAIC), które umożliwia stworzenie deepfake’a na bazie jednego zdjęcia i jednego ujęcie. Sami przyznacie, że efekty zaprezentowane na filmie opublikowanym na Youtube robią wrażenie! Możemy na nim zobaczyć, że w zależności od twarzy, na którą nakładamy dane zdjęcie, efekty mogą się nieznacznie od siebie różnić. Warto dodać, że spece zapewniają, iż większa ilość materiału pozwoli rozbudować mimikę „ożywianej” postaci, dając znacznie lepszy efekt.

Mona Lisa, która wreszcie przestała się tajemniczo uśmiechać, Marylin Monroe, która „powróciła” z zaświatów… Niezła rozrywka? No jasne. Szkoda tylko, że to jednocześnie olbrzymia siła napędowa dla fake newsów, które już teraz mają się całkiem dobrze. Wyobrażacie sobie możliwości szerzenia fałszywych informacji (które mogą np. wpłynąć na wyniki wyborów), skoro wkrótce już każdy – i to za pomocą jednej fotografii – będzie mógł „zanimować” dowolną postać? Zresztą nie musicie sobie tego wyobrażać… Wystarczy, że obejrzycie jeden odcinek świetnego serialu HBO „Rok za rokiem”. Konsekwencje takich manipulacji są tam przedstawione w dosadny sposób.

Dlatego mamy cichą nadzieję, że nawet jeśli do tej pory bez zastanowienia wysyłaliście i udostępnialiście swoje fotki w sieci, za pośrednictwem maili czy popularnych komunikatorów, zaczniecie to robić z większą rozwagą. A tymi najbardziej intymnymi obrazkami będziecie się dzielić jedynie za pomocą naprawdę bezpiecznych narzędzi lub zachowacie je dla własnych oczu. Choć, jak widać na załączonych obrazkach, i własnym oczom coraz trudniej wierzyć.

AJ